Разве есть на свете что-то более странное и столь наглядно описывающее наше безумное время, чем вот это видео?

На нем актриса Элисон Бри рассказывает что-то про рестлинг, но узнать даму можно разве что по голосу и изящному декольте — в остальном она вылитый Джим Керри с карэ. Для тех, кто отстал от жизни, поясняем. Это вовсе не магия и не фотошоп, а качественный deepfake — синтезированное видео, использующее в качестве основы лица разных людей, которые мастерски накладываются одно на другое продвинутой нейросетью.

Как работают нейросети, и что они умеют

Нейросеть — система процессоров, способных к обучению. Например, нам нужно, чтобы нейросеть различала часы и трусы. Для этого мы загружаем в систему здоровенный пак картинок с часами и трусами, которым система выдает соответствующие числовые значения. После этого оператор вручную корректирует значения для часов и трусов, тем самым «обучая» нейросеть. Через какое-то время система начинает хорошо различать одно от другого, а также распознает и «понимает» значения новых подобных картинок.

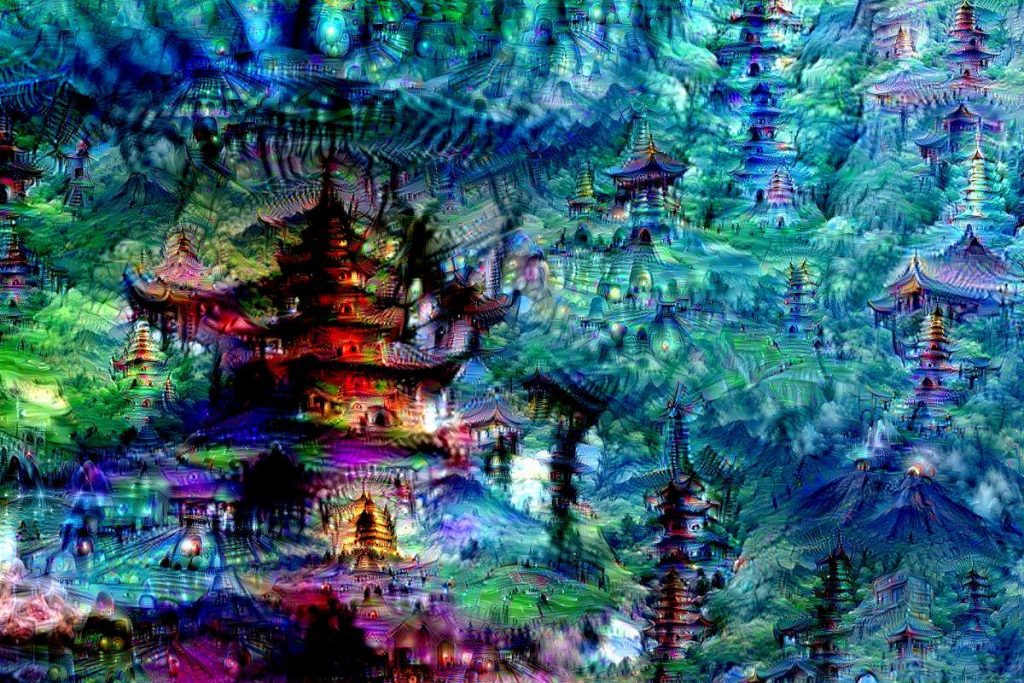

Картина, нарисованная нейросетью

Картина, нарисованная нейросетью

По тем же принципам нейросети отлично работают в медицине как системы диагностики, в бизнес-аналитике и даже в искусстве. Нейросети пишут стихи, сценарии, песни и рисуют картины, опираясь на огромные базы данных. Отличным примером является творчество группы «Нейронная оборона», тексты для которой пишет нейросеть, шарящая в творчестве Егора Летова возможно даже лучше, чем он сам когда-то.

А вот научно-фантастическая короткометражка, сценарий к которой написала нейросеть:

Нейросети посложнее работают с большим количеством алгоритмов. В 2014 году студентом Стэнфордского университета Яном Гудфеллоу была создана генеративно-состязательная нейросеть (GAN), один алгоритм которой обучается на фотографиях человека и создает из этого изображение, а второй — «борется» с ним, пока первый алгоритм не начинает путать копию и оригинал. Именно эта постоянно усложняющаяся нейросеть и рождает дипфейки (deepfake — образовано из сочетания deep learning, «глубинное обучение» и fake, «подделка»).

Дипфейк, созданный нейросетью к 115-летию со дня рождения Сальвадора Дали:

Впервые нечто отдаленно напоминающее deepfake появилось в Сети еще на заре ее становления. Связано это было, разумеется, с сексом.

В те далекие годы, когда юзеры еще переходили по сомнительным рекламным баннерам с сообщениями вроде «Что? Да! Теперь ты можешь раздеть любую девушку, стоит только…». По ссылке похотливый пользователь либо скачивал себе какой-нибудь троян, либо переходил на сайт с откровенными картинками, демонстрирующими невероятные возможности его «умного алгоритма», который «всего за сто рублей может раздеть догола девушку на любой фотографии».

Все это выглядело примерно вот так

Все это выглядело примерно вот так

Радостный юзер высылал указанную сумму куда-то в неизвестность, закачивал на сайт снимок и чаще всего не получал ничего, а в лучшем случае ему показывали шаблон с обнаженным женским телом, к которому было коряво подставлено лицо девушки с фото. Иногда пользователь получал и нечто более удобоваримое, однако в этом случае речь уже шла о ручной обработке снимка в фотошопе под заказ — но это уже совсем другая история.

В 2017 году в сети начали всплывать новости о том, что некая нейросеть научилась заменять в порно лица актрис лицами голливудских звезд.

Старожилы немного напряглись — неужели опять речь идет о тех самых шаблонах? Однако выяснилось, что дело не в них, а в той самой нейросети GAN, которая теперь может дополнять адаптивным алгоритмом видео и заменять лицо героя (героини) на любое другое.

Первые попытки сделать порно со знаменитостями выглядели так себе (нечеткие края лиц и дерганная мимика), но через какое-то время видосы с той же Галь Гадот стали настолько реалистичными, что даже PornHub запретил публикации подобных роликов.

Именно тогда интернет и заговорил о дипфейках как о новой «чуме XXI века», от которой может пострадать не только репутация известных людей, но и мир в целом, поскольку с развитием алгоритмов нейросетей технология и ее внедрение в обиход будут лишь усложняться. А это значит, что в скором времени каждый из нас без особых проблем сможет примерять на себя лица других, а также в прямом смысле раздевать кого-угодно одним лишь тапом по смартфону — сплошное раздолье для мошенников и шантажистов всех мастей.

В 2019 году в сети появилась реклама приложения DeepNude, способного с помощью нейросети раздеть кого угодно.

Тут старожилы не просто напряглись, а чуть не выли от радости — теперь-то им точно удастся нормально раздеть не только любимую знаменитость, но и соседку. И приложение явно не разочаровало — нейросеть настолько ловко и удачно подбирала тон кожи, линии округлостей и даже цвет сосков, что на сайт с программой в день старта прибежала целая толпа народа, алчущая цифровой обнаженки.

В итоге похотливые юзеры просто уронили сайт, а может быть это сами создатели прикрыли лавочку, когда на их сомнительную нейросеть обратили внимание СМИ — здесь мнения разнятся. Но через несколько дней после открытия твиттер DeepNude разразился тирадой о закрытии проекта и о том, что «мир к нему еще не готов»:

В любом случае «провернуть фарш назад» было уже нельзя. Соцсети взорвались возмущенными постами о объективации женщин, посягательстве на частную жизнь и прочих нехороших вещах, которыми нейросеть DeepNude могла нарушить тихий быт женщин планеты — а ведь твиттере разработчики в свое время обещали еще и за мужчин взяться.

Все почувствовали себя крайне уязвимыми перед нейросетью, которую журнал Vice назвал «ужасающей», а сеть потихоньку заполнилась вот такими фотографиями (действительно ли это работа DeepNude или потрудились мастера фотошопа — неизвестно):

Но развитие технологий в любом случае остановить уже невозможно. Буквально на днях стало известно, что китайцы создали приложение Zao, которое позволяет за считанные секунды вставить свое лицо в любое видео — настолько крутая нейросеть там работает. Но проверить это пока невозможно, поскольку доступно приложение лишь на китайском рынке. Поэтому и лица на видосах соответствующие:

Чем же опасны дипфейки помимо того, что они всех подряд «раздевают»?

А опасность в том, что помимо репутационных потерь люди рискуют в скором будущем очутиться в мире, где любая информация может быть подделкой. Не будет доверия ни к самым правдоподобным видеозаписям, ни к изображениям, ведь все это может оказаться результатом работы продвинутой нейросети, управляемой откуда-то извне.

А еще нейросети смогут распознавать наши лица даже с фотографий в низком качестве, так что укрыться от них не получится

А еще нейросети смогут распознавать наши лица даже с фотографий в низком качестве, так что укрыться от них не получится

Качественные дипфейки станут серьезнейшими рычагами не только для мошенничества, шпионажа и вымогательства, но и для манипуляции общественным сознанием, и это не просто выкрик параноика — еще в прошлом году военные компании из США оплатили целую кучу опытов по созданию дипфейков и распознаванию работы новейших ИИ. Так что не спешите убирать шапочки из фольги — в ближайшем будущем они могут понадобиться.

Однако, несмотря на всю опасность, у дипфейков есть и плюсы. Да, какие-то из этих роликов выходят за грань дозволенного, но сегодня их подавляющее количество в Сети — всего лишь безобидные, по-хорошему отбитые и смешные видосы про то, как кому-то приклеили лицо Николаса Кейджа или Арнольда Шварценеггера. Только представьте возможность использования дипфейков в кино и пародиях — там их перспективы реально безграничны.

Дипфейки с Николасом Кейджем:

Отечественный дипфейк, в котором у «Ангелов Чарли» лица Михаила Ефремова:

Билл Мюррей в роли сержанта Хартмана из «Цельнометаллической оболочки»:

Опра с лицом Майка Тайсона:

Тайлер Дерден с лицом Эдварда Нортона:

Джокер в «Истории рыцаря»:

«Сияние» с Джимом Керри вместо Джека Николсона:

Киану Ривз в роли Фореста Гампа:

Брюс Ли в роли Нео:

Сильвестр Сталлоне играет Терминатора Т-800:

Комик Билл Хейдер пародирует Шварцнеггера:

А также Аль Пачино:

А еще Тома Круза:

Крис Д’Элия пародирует Киану Ривза:

Эдди Мерфи пародирует Билла Косби:

P.S. А еще совсем скоро у заснятых в неположенных местах и пикантных позах мужчин и женщин может появиться новая отмазка, что это не они ходили «налево», а какой-то злодей попросту подставил их, применив нейросети против порядочных людей. Воистину, это киберпанк, который мы заслужили.

Украинские подвиги Кутузова

Украинские подвиги Кутузова